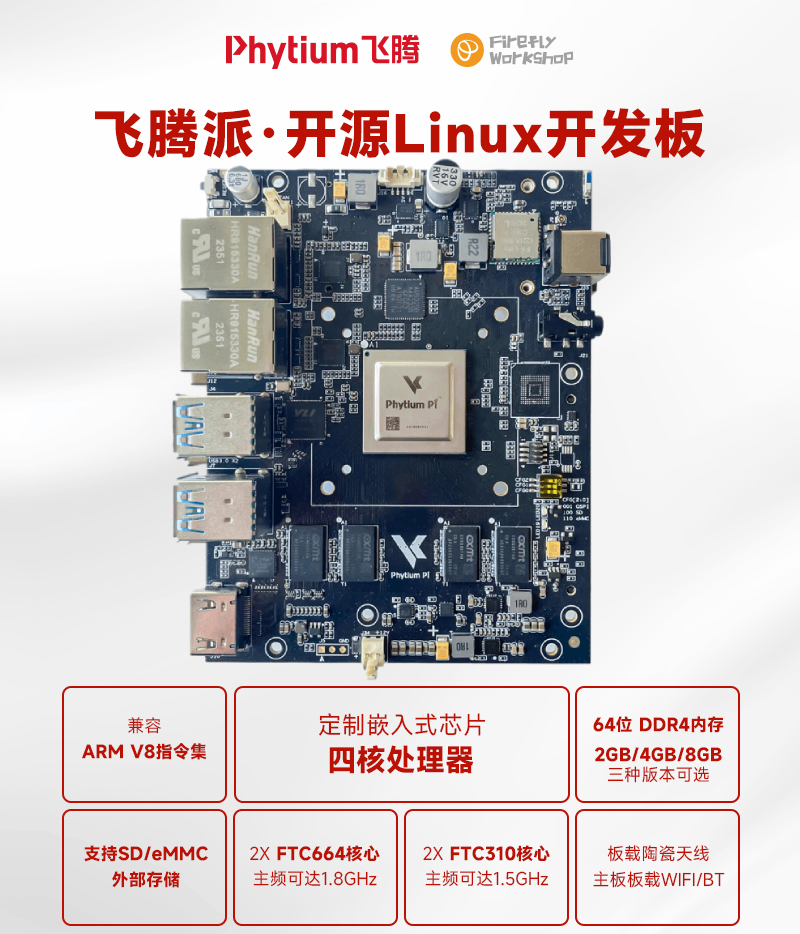

最近DeepSeek爆火,成功吸引了大众的目光,也让大家对国产AI的关注度持续攀升,DeepSeek作为国产AI领域的杰出代表之一。它不仅在语言理解、文本生成、知识问答等任务上表现出色,还具备强大的学习能力和适应性,能够快速适应多种应用场景。而飞腾派作为一款国产自主可控的开源硬件,凭借其高性能和灵活的开发环境,同样是众多开发者探索创新的选择。今天就给大家分享一个在飞腾派上部署DeepSeek-r1:1.5b模型的教程,让我们一起体验国产AI智能发展带来的无限可能吧。V8Pesmc

V8Pesmc

V8Pesmc

教程详情V8Pesmc

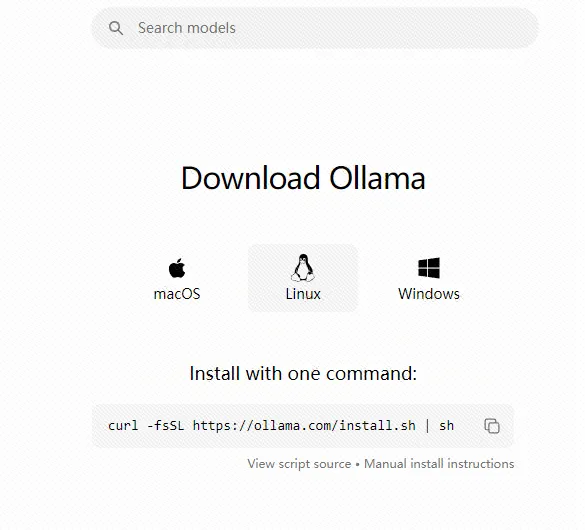

一、安装ollamaV8Pesmc

为了让大家更高效地完成部署,我们提供了ollama的离线安装包和在线安装两种方法。V8Pesmc

方法一:在线下载,只需要输入下载指令即可进行在线安装。V8Pesmc

curl -fsSL https://ollama.com/install.sh | sh V8Pesmc

V8Pesmc

V8Pesmc

方法二:离线安装包,在⽹盘中下载 ollama-linux-arm64.tgz ,解压到指定路径V8Pesmc

sudo tar -xzvf ollama-linux-arm64.tgz -C /usr/ V8Pesmc

网盘链接 : https://pan.baidu.com/s/1A1laIfddL8PzLJq-2i6o4A V8Pesmc

提取码 : 5x4rV8Pesmc

二、配置服务器V8Pesmc

配置组V8Pesmc

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama V8Pesmc

sudo usermod -a -G ollama $(whoami)V8Pesmc

创建服务,使⽤ vim 创建 /etc/systemd/system/ollama.service 并加⼊以下内容V8Pesmc

[Unit] V8Pesmc

Description=Ollama Service V8Pesmc

After=network-online.target V8Pesmc

[Service] V8Pesmc

ExecStart=/usr/bin/ollama serve V8Pesmc

User=ollama V8Pesmc

Group=ollama V8Pesmc

Restart=always V8Pesmc

RestartSec=3 V8Pesmc

[Install] V8Pesmc

WantedBy=default.target V8Pesmc

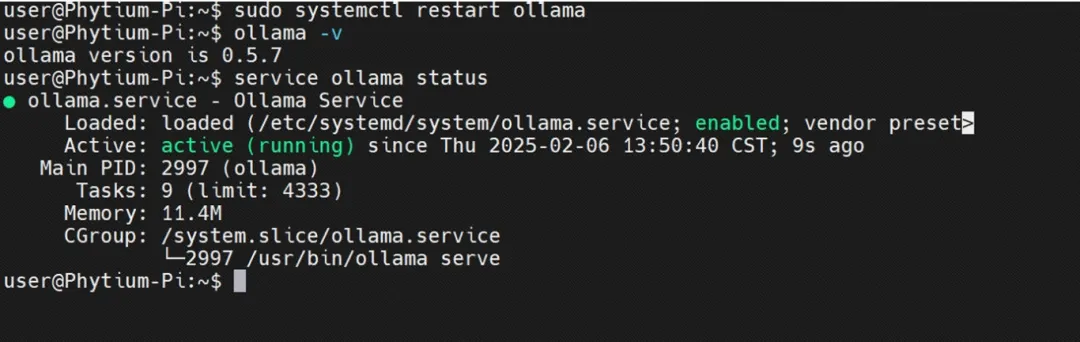

启动服务器V8Pesmc

sudo systemctl daemon-reload V8Pesmc

sudo systemctl enable ollama V8Pesmc

sudo systemctl restart ollama V8Pesmc

查看 ollama 服务,可以看到已经正常启动V8Pesmc

V8Pesmc

V8Pesmc

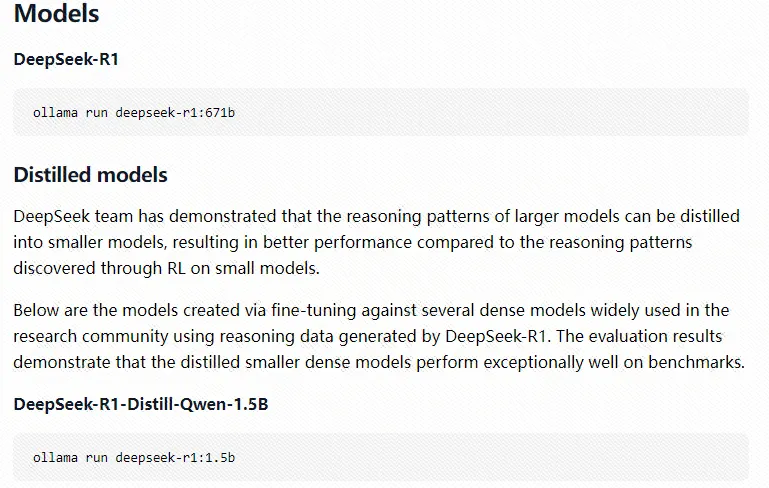

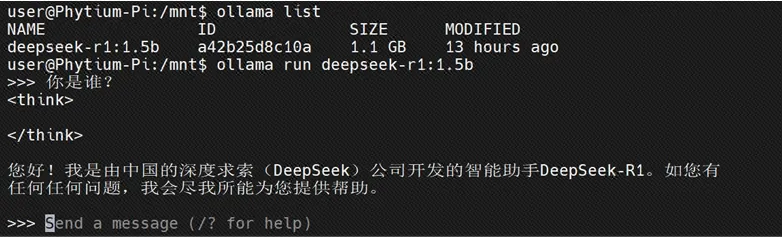

三、运⾏deepseek-r1:1.5bV8Pesmc

首次运行deepseek-r1:1.5b,会自动在线下载模型。V8Pesmc

ollama run deepseek-r1:1.5b V8Pesmc

V8Pesmc

V8Pesmc

由于近期DeepSeek太火爆,在线下载过于拥堵可能会出现失败的情况,可从网盘中下载模型,解压到 /usr/share/ollama/.ollama/models/V8Pesmc

sudo tar -xzvf models.tar.gz -C /usr/share/ollama/.ollama V8Pesmc

网盘链接 : https://pan.baidu.com/s/1A1laIfddL8PzLJq-2i6o4A V8Pesmc

提取码 : 5x4rV8Pesmc

下载成功后,再次输入启动指令V8Pesmc

ollama run deepseek-r1:1.5b V8Pesmc

V8Pesmc

V8Pesmc

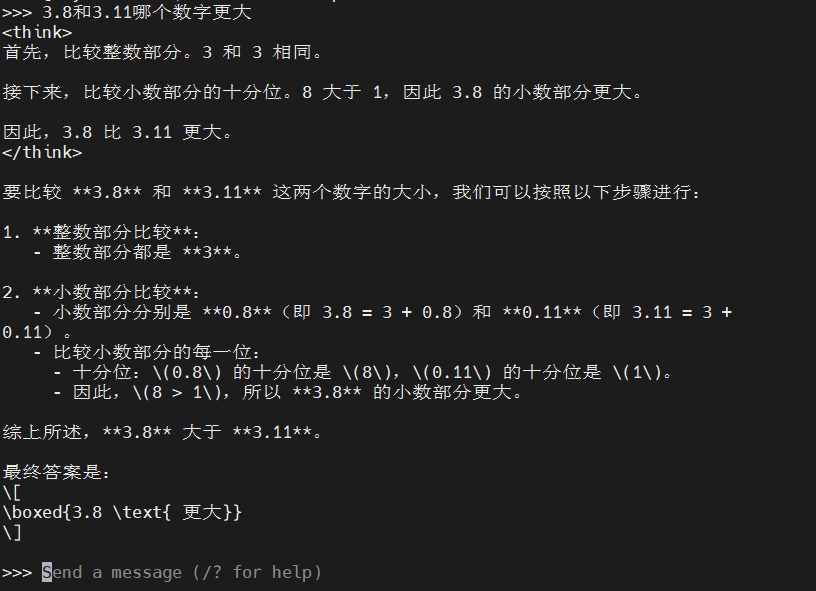

部署成功!尝试提问测试V8Pesmc

V8Pesmc

V8Pesmc

回答正确!飞腾派成功运行DeeSeek模型啦!现在大家可以充分利用飞腾派硬件优势,持续培训 DeepSeek,挖掘模型的更多潜力,探索更多创意应用,期待大家创造出精彩的成果!V8Pesmc

责编:GreatAE