热门标签

随着人工智能/机器学习(AI/ML)在全球范围内的迅速兴起,2020年,以高带宽内存(HBM、HBM2、HBM2E、HBM3)为代表的超带宽解决方案开始逐渐显露头角。

进入2023年后,以ChatGPT为代表的生成式人工智能市场的疯狂扩张,在让AI服务器需求迅速增加的同时,也带动了HBM3、DDR5等高阶产品的销售上扬。Kowesmc

TrendForce的调研显示,HBM现在几乎已成为高端AI服务器GPU的标准配置,预估今年全球HBM的年需求量将增长约60%,即从2022年的1.81亿GB增加到2.9亿GB,2024年还将再成长30%。Kowesmc

目前,谷歌、亚马逊、微软等涉足云服务器业务的全球科技巨头越来越多地采用HBM产品,尤其是HBM2E。芯片厂商中,NVIDIA A100/A800、AMD MI200芯片均采用HBM2E;NVIDIA H100和AMD MI300X采用了SK海力士数据速率为5.6GT/s的12层24GB HBM3;SK海力士、三星和美光三家存储芯片大厂则分别以50%、40%、10%的比例瓜分了全球HBM市场份额。Kowesmc

HBM技术于2013年推出,是一种高性能3D堆栈DRAM构架,数据传输速率大概可以达到1Gbps左右。此后,该技术标准差不多每隔2-3年就会更新一代,使得第二代(HBM2)、第三代(HBM2E)、第四代(HBM3)和第五代(HBM3E)产品的带宽和最高数据传输速率记录被不断刷新。鉴于同期内其他产品的带宽仅增加两到三倍,我们有理由将HBM产品的快速发展归功于存储器制造商之间激烈的竞争。Kowesmc

早在2021年,SK海力士和Rambus就已先后发布最高数据传输速率6.4Gbps和8.4Gbps的HBM3产品,每个堆栈提供超过665GB/s和1075GB/s的传输速率;今年4月,SK海力士成功实现垂直堆叠12个单品DRAM芯片,最高容量24GB的HBM3 DRAM新产品;7月,美光最新出样的8层堆叠24GB容量第二代HBM3内存带宽超过1.2TB/s,引脚速率超过9.2Gb/s,能使大型语言模型的训练时间缩短30%以上。 Kowesmc

Kowesmc

Kowesmc

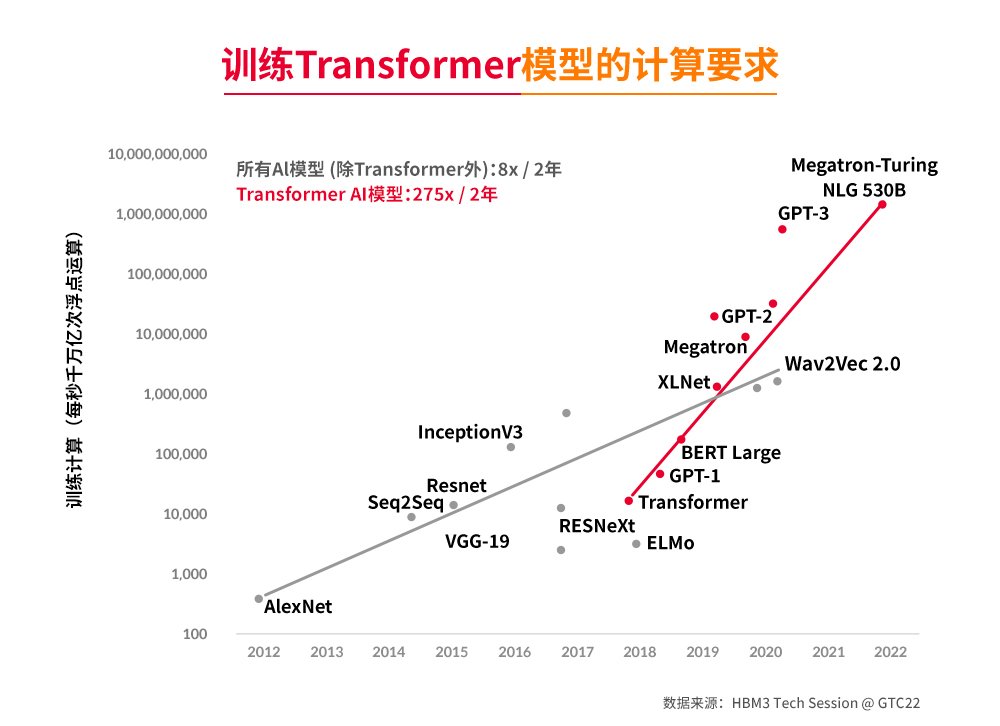

训练模型的计算性能趋势(来源:SK hynix Tech Session @GTC2022)Kowesmc

相关机构预测称,SK海力士和三星的下一代产品,包括HBM3和HBM3E,将在明年主导相关芯片市场。而为了满足需求,三星和SK海力士不但预计将于今年下半年到明年第一季度期间发布HBM3E样品,并于2024年下半年开始量产,还计划于明年将HBM芯片产量提高一倍,并减少其他类别存储芯片的投资,尤其是库存水平较高、盈利能力差的NAND。Kowesmc

《BusinessKorea》在最近的一则报道中指出,为了实现上述目标,两家公司计划在明年年底前投资超过2万亿韩元。其中,SK海力士计划利用利川现有HBM生产基地后的清州工厂的闲置空间,三星电子正在考虑扩大位于忠清南道天安市的HBM核心生产线,该地区是设备解决方案部门下的先进封装团队的所在地。Kowesmc

虽然三星和SK海力士没有透露HBM的具体价格,但据SemiAnalysis披露,HBM3的价格大约是标准DRAM芯片的5-6倍,预计到2026年,HBM占全球内存收入的比例将从当前的不到5%增长到20%以上。这就是为什么今年HBM出货量仅占DRAM总出货量的1.7%,但其销售额比例却达到了11%,英伟达、AMD、微软、亚马逊等芯片大厂排队抢货,甚至溢价也可考虑的原因。Kowesmc

这样的市场表现对于提高存储半导体公司的业绩也有积极的影响。Kowesmc

SK海力士在7月26日举行的第二季度业绩发布会上解释说,“与上一季度相比,第二季度DRAM的平均售价(ASP)‘以高个位数百分比’上涨,这是由于销售了许多高附加值产品的影响。”同时披露的财报也显示,尽管SK海力士第二季度营业亏损为2.88万亿韩元,但其股价上周却上涨了12%。Kowesmc

次日,三星宣布第二季度营业利润为6685亿韩元,同比下降95.26%。但受益于最新一代HBM3、DDR5芯片等高端内存技术订单激增的影响,三星股价当日上涨了2.4%。Kowesmc

根据NVIDIA的定义,目前DL/ML型AI服务器平均每台均搭载4张或8张高端显卡,搭配两颗主流型号的x86服务器CPU,主要出货厂商来自于Google、AWS、Meta、Microsoft、百度、字节跳动等公司。据TrendForce集邦咨询预估,今年AI服务器出货量年增率可望达15.4%,2023-2027年AI服务器出货量年复合成长率约12.2%。Kowesmc

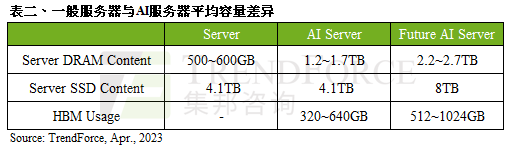

显而易见,这将大幅带动存储器需求成长。以现阶段一台标准通用服务器为例,其DRAM配置规模约为500-600GB左右,而AI服务器在单条模组上可达64-128GB,平均容量约为1.2-1.7TB。同时,由于AI服务器追求更高的运算和传输速度,在接口上会优先采用PCIe 5.0,这使得相较于一般服务器而言,AI服务器会增加GPGPU的使用量,因此若以4或8张NVIDIA A100 80GB配置计算,HBM用量约为320-640GB。可以预见的是,未来在AI大模型日趋复杂化的趋势下,将刺激更多的存储器用量,并同步带动服务器DRAM、企业级SSD和HBM的需求成长。Kowesmc

Kowesmc

Kowesmc

这一趋势在SK海力士的财报电话会议上,得到了首席财务官金祐贤(Kim Woohyun)的认同。他指出,随着以ChatGPT为中心的生成式AI市场的扩大,与传统服务器相比,AI服务器使用的内存至少多出1-8倍,以实现更快的计算处理,并采用HBM3和DDR5 DRAM等高性能内存产品,这不仅会推动需求,而且对盈利能力产生了积极影响。Kowesmc

他还表示,虽然全公司投资规模同比减少50%以上的基调没有变化,但公司将利用通过经营效率化确保的资金,针对今后主导市场的高容量DDR5、HBM3 DRAM,持续投资扩大生产能力。据BusinessKorea 报道,SK海力士的目标是在明年将HBM和DDR5芯片的销量翻一番。Kowesmc

与此同时,三星也已开始向主要的AI SoC公司和云计算公司发货8层16GB和12层24GB HBM3产品,并计划到2024年将HBM产能增加到2023年的两倍。而据当地券商KB Securities称,到2024年,HBM3将占三星芯片销售收入的18%,高于今年预计的6%。三星负责芯片业务的设备解决方案部门总裁兼负责人Kyung Kye-hyun在7月早些时候的公司会议上表示,三星将努力控制50%以上的HBM市场,高于现在的40%。Kowesmc

美光最新的DRAM四年路线图则显示,其HBM3E预计将在2024年第三季度/第四季度开始出货,正在开发的HBMNext内存产品将为每个堆栈提供1.5TB/s – 2+TB/s的带宽,容量范围为36GB至64GB。Kowesmc

目前来看,作为一项重要的技术创新,HBM的发展前景是相当光明的,尤其是在人工智能训练应用中。但对比GDDR DRAM动辄16/18Gbps的速率,HBM3的速率即便达到9.2Gbps,也仍然存在差距,而限制HBM发展的原因则主要来自两方面:一是中介层,二是3D堆叠带来的复杂性和制造成本的增加。但我们相信,随着全球存储三巨头的深度介入,上述挑战终将得到解决,HBM市场的激战也会愈演愈烈。 Kowesmc

微信扫一扫,一键转发

关注“国际电子商情” 微信公众号

2025年3月16日,中共中央办公厅、国务院办公厅印发《提振消费专项行动方案》并发出通知。其中涉及到“人工智能+”行动,促进“人工智能+消费”。

本文从观察到的两个有趣的市场与宏观趋势出发,来观览这高速发展、属于人类技术与生产力变革史的后续四五十年。

"以后只有用我们的鸿蒙PC了。”

“最近,存储现货市场出现止跌的信号,预计在2025年Q2,NAND产品的价格将率先企稳,2025年Q3整体存储价格有机会迎来回升。”

国际电子商情讯,据《华尔街日报》最新报道,美国政府正酝酿对中国AI公司DeepSeek采取一系列限制措施,其中最为引人注目的是可能禁止在政府设备上使用DeepSeek聊天机器人。美国政府此举引发了各界的关注。

到2029年,Agentic AI将取代80%的人工客服。

早在2019年,笔者就在一篇文章中表示,即便当时游戏业务占到NVIDIA总营收的54%,数据中心业务的高速增长势头却也已经表现得非常明确。而根据NVIDIA Q4 FY2025(截止2025年1月26日)季报,与数据中心业务的大热相较,NVIDIA的游戏业务(Gaming)当季营收为25.4亿美元,不说连计算加速卡的零头都没到,还环比跌了22%,同比跌11%。

安森美已准备好“应对长期波动”。

黄仁勋夸爆DeepSeek!

国际电子商情讯,北京时间今日凌晨,天风国际证券分析师郭明錤在其社交平台X发文称,2025年初首批Intel/IFS 18A先进制程生产的Panther Lake工程样品的生产良率不到20%-30%。他指出,该生产良率对英特尔下半年要量产的目标而言并非易事。

苹果称,这是其有史以来最大规模的支出承诺。

电子产品供应链正面临需求激增、短缺和中断的日益严峻的压力。未来十年,强化数据分析将重塑运营,提升预测能力、效率和应变能力。

美通社消息,3月14日,“2025英飞凌消费、计算与通讯创新大会”(ICIC2025)在深圳举行。本届大会汇聚600多位业界精

近日,湖南省工信厅发布了《2025年湖南电子信息制造业重点项目名单》,涵盖先进计算、音视频、新一代半导体、人

3月15日,质鼎集团公众号消息,惠科东莞平板显示集群电子商务项目二期正式开工。

富士康、台积电、广达、华硕、联发科、友达光电等中国台湾20家电子企业2024年第四季度和全年财报汇总。

近年来,LED显示屏市场持续演进。回顾2024年,行业呈现出哪些发展态势?展望2025年及未来,市场又将面临哪些机遇与

近日,索尼正式发布新一代RGBLED背光技术系统,可实现4000尼特峰值亮度。索尼计划该系统将于2025年开始量产,并将

AI芯片是半导体最大的增长点,先进封装则是制造AI芯片的关键技术。此前英伟达H100成本约3000美元,而用先进封装

截止2024年底,17家欧美固态电池企业融资总额已突破42亿美元。

曾几何时,中国半导体几乎不断有大基金投资、大项目上马,以及美国制裁的新闻。长期处于聚光灯下,中国半导体成为

Dynabook在退出十年后宣布重返美国消费市场。

Canalys最新数据显示,受到消费需求激增8%的推动,2024年第四季度中国大陆的PC市场开始复苏,同比增长2%。

根据TrendForce集邦咨询最新调查,2024年第四季由于Apple(苹果)手机生产进入高峰,以及中国部分地方提供消费补贴

德州仪器近日推出了全球超小型 MCU,进一步扩展了品类齐全的 Arm® Cortex®-M0+ MSPM0 MCU 产品组合。

创新是企业持续发展最大的价值。

“闪迪(Sandisk)又回来了!”在3月12日的存储年度盛会CFMS MemoryS 2025上,闪迪公司全球产品副总裁Eric Spa

摩尔斯微电子推出合规的Wi-Fi HaLow片上系统(Soc),开启欧洲连接技术新纪元。超低功耗、远距离连接功能现已为

CFMS | MemoryS 2025已圆满落幕,期间包括三星电子、长江存储、铠侠、美光、闪迪、高通、Arm、慧荣科技、S

Hyperlux™ ID iToF 系列将深度测量距离提升至最远 30 米,提高工业环境中的生产效率和安全性

26TB大容量CMR HDD助力WD Red Pro与G-DRIVE/G-RAID系列专业级产品矩阵,赋能数据存储拓展与生产力跃升

全新一代MCU可以满足各种区域控制架构和电气化系统需求,助力汽车制造商向软件定义汽车(SDV)过渡。

将出色的高

聚洵半导体科技(上海)有限公司(Gainsil Semiconductor Technology)于2016年成立于上海张江科学城,是一家全球

领域新成果领域新成果4月必逛电子展!AI、人形机器人、低空飞行、汽车、新能源、半导体六大热门新赛道,来NEPCO

后量子加密技术帮助保护数字基础设施免受量子计算机在将来带来的潜在威胁。

英飞凌坚信低碳化和数字化是未来十年的关键驱动力,半导体在应对能源挑战和推动数字化转型中扮演着重要角色。

近期热点

EE直播间

更多>>在线研讨会

更多>> 点击查看更多

Copyright © 2000-2025 eMedia Asia Ltd. All rights reserved.

北京科能广告有限公司深圳分公司 版权所有

分享到微信

分享到微博

分享到QQ空间

推荐使用浏览器内置分享

分享至朋友圈