从数据中心到边缘侧,英特尔全方案助力AI加速落地

为了支持对AI的需求,英特尔在最近几年在持续发布并更新AI加速器、支持大模型的软件栈、支持端侧AI需求的分离式显卡、内置GPU、CPU、NPU的处理器,以及面向AI的开源软件等产品。

2024年7月25日,在由专业电子机构媒体AspenCore与深圳市新一代信息通信产业集群联合主办的联合主办的“2024国际AIoT生态发展大会”上,英特尔中国解决方案架构师杨涛分享了该公司持续的算力创新动态。b2Aesmc

他指出,近年来随着生成式AI的火爆,芯片行业有两大趋势日益突显——预计在未来两年内,约有80%的企业会部署生成式AI,对产业而言这是极大的市场机会。另外,约有50%的边缘计算设备具备机器学习功能,芯片企业需为端侧设备增加AI处理算力。b2Aesmc

在此背景下,杨涛介绍了英特尔在算力创新方面的一些动态。为了支持对AI的需求,英特尔在最近几年在持续发布并更新AI加速器、支持大模型的软件栈、支持端侧AI需求的分离式显卡、内置GPU、CPU、NPU的处理器,以及面向AI的开源软件等产品。b2Aesmc

b2Aesmc

b2Aesmc

支持AI训练/推理的加速器和软件生态

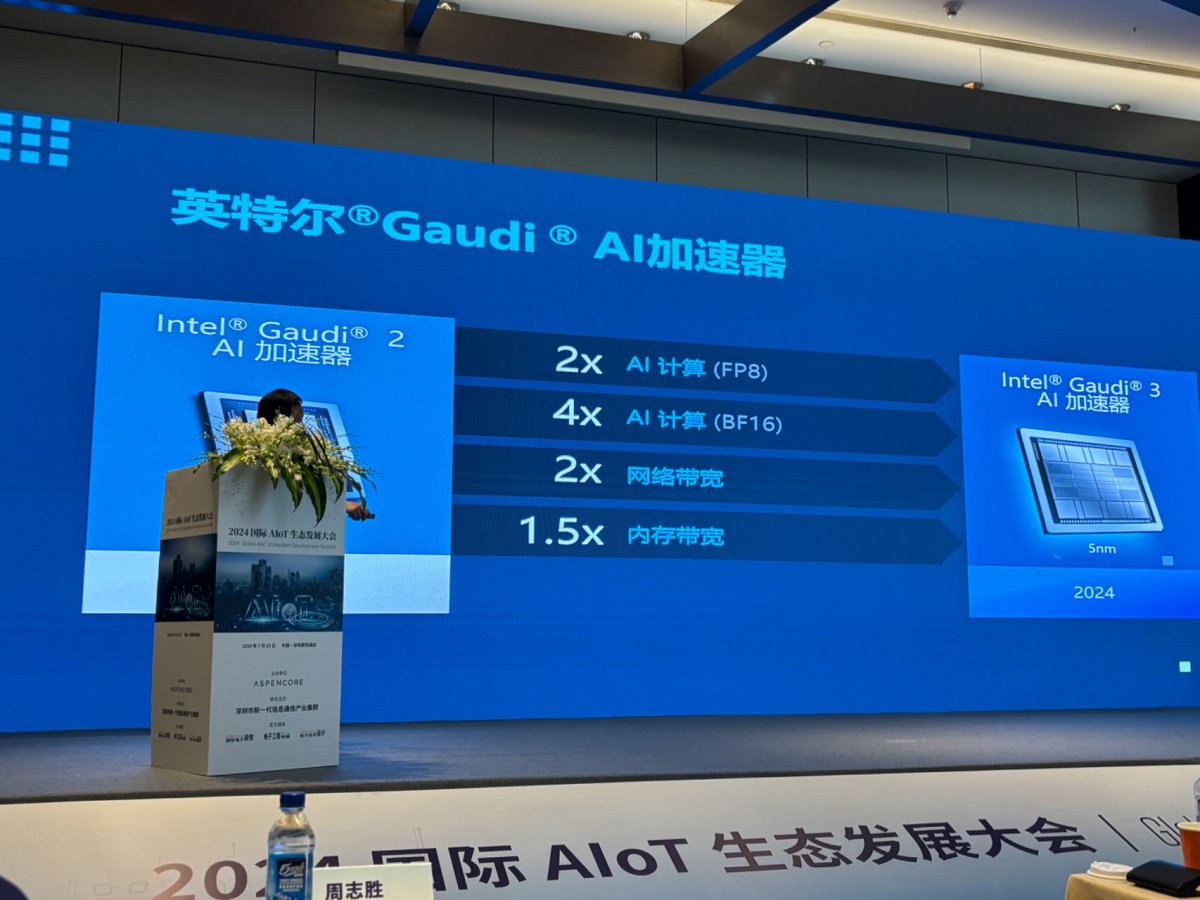

英特尔先后发布了两款AI芯片——Gaudi® 2和Gaudi® 3——是面向数据中心主推的AI训练/推理芯片。b2Aesmc

Gaudi® 2在2023年发布,采用了台积电7纳米技术,Gaudi® 3在2024年发布,采用了台积电5纳米技术。Gaudi® 3与前一代相比有诸多提升,比如在AI FP8(8位浮点数)算力提升2倍,BF16算力提升了4倍;同时网络带宽提升2倍,内存带宽提升1.5倍。b2Aesmc

b2Aesmc

b2Aesmc

在杨涛看来,在大芯片上集成AI还存在较大的门槛。“门槛主要体现在软件生态方面,许多公司虽然推出了性能指标非常高的芯片,但是这些芯片如何与大模型公司结合仍存在挑战,而英特尔的AI芯片在软件生态上的适配度非常好。”b2Aesmc

在今年4月,Meta发布了Llama 3大模型,紧接着,在7月24日,该公司又发布了升级版的Llama 3.1。在上述大模型发布的当日,英特尔就宣布自己的AI产品组合支持这些大模型,并通过开放生态系统软件实现针对性优化,这涵盖了 PyTorch 及英特尔® PyTorch 扩展包、DeepSpeed、Hugging Face Optimum库和vLLM等。b2Aesmc

杨涛还介绍说,英特尔针对国内的大模型用户也有新动态。例如,上个月,阿里云发布了通义千问Qwen2大模型,英特尔在该模型发布的当天,也发布了支持通义千问Qwen2大模型的软件栈。“我们想强调的是,英特尔不仅有单一的AI指标,同时也有非常好的软件生态,能第一时间支持最新的大模型。”b2Aesmc

支持端侧的分离式显卡

除了应用在数据中心训练/推理场景的AI产品之外,英特尔也支持对端侧AIoT领域的AI算力提升。例如,英特尔在显卡领域已经布局很多年,但此前主要面向传统的PC集成显卡(核显)市场,多年来独立显卡市场一直被英伟达和AMD占据。b2Aesmc

最近几年, 先是全民“挖矿”风潮兴起,紧接着又是生成式AI爆红,显卡的核心功能也从加速图形渲染,扩大到加速HPC高性能计算、DL深度学习、AI人工智能等能力上。一时间,显卡成为这几年红到不能再红的“炸子鸡”。b2Aesmc

面对如此庞大的显卡市场,英特尔也开始加强在显卡领域的布局。2022年3月30日,英特尔正式发布最新的独立显卡,该显卡被命名为Intel ARC(中文名为锐炫)。到2024年,Intel ARC系列更新到了第二代,其GPU max系列产品针对数据中心超算部署。b2Aesmc

b2Aesmc

b2Aesmc

英特尔的独立显卡均采用Xe GPU架构,该架构下的产品细分为主打集成显卡和入门独显的超低功耗Xe LP、针对游戏优化的高性能图形Xe LPG、面向数据中心和AI应用的高性能Xe HP、适合超级计算的高性能计算Xe HPC四种微架构。这些不同架构的显卡为不同应用场景优化,完整覆盖集成显卡、入门级独显、主流独显、旗舰独显、工作站、服务器数据中心、流媒体编解码、AI、HPC和超算等各个细分领域。b2Aesmc

端侧设备有大量的AI需求,而如何去满足这些设备的AI算力是芯片企业需要考虑的问题。今年6月,在Computex 2024期间,英特尔CEO帕特·基辛格公布了下一代AI PC旗舰处理器Lunar Lake的架构细节。据介绍,该处理器在图形和AI处理能力上有较大提升,并且着重提高了轻薄本的高能效计算性能。Lunar Lake 将降低最高达40%的SoC功耗和带来超过3倍的AI算力。该处理器于2024年第三季度出货。b2Aesmc

b2Aesmc

b2Aesmc

具体来看,下一代AI PC旗舰处理器Lunar Lake集成了CPU、GPU、NPU,这些器件总计带来了120TOPS的AI算力——CPU通过添加向量指令支持AI,可以带来5TOPS的算力,内置的GPU算力高达67TOPS,同时还带矩阵计算能力,NPU(神经网络处理器)带来更高的效率,带来了最高48TOPS的算力。b2Aesmc

AI开源深度学习工具包

与数据中心领域一样,不仅有算力挑战,还有软件生态的挑战。边缘侧也面临着算力和软件层面的挑战。英特尔为了实现在多种硬件平台上进行优化的神经网络推理,加速AI工作负载的处理,并缩短开发周期,推出了一个深度学习工具包OpenVINO。b2Aesmc

b2Aesmc

b2Aesmc

该工具包采用了一种“一次编写,随处部署”的方法,特别针对英特尔硬件平台进行了优化,包括CPU、GPU、VPU和FPGA。OpenVINO的支持涵盖了从模型选择、优化到部署的整个流程,使得开发人员能够更高效地利用英特尔硬件加速AI应用的开发和部署。b2Aesmc

这是一个开源的软件,不仅支持英特尔的芯片架构,也支持第三方的芯片架构,“这是一个针对端侧、边缘侧的AI推理的软件框架,我们希望能够适用于各种边缘应用、AI PC,及云端CPU。”最后,杨涛指出,OpenVINO的大概的发展方向有三个:第一,模型训练;第二,模型优化;第三,模型部署。b2Aesmc

-

微信扫一扫,一键转发

-

关注“国际电子商情” 微信公众号

- 上市分销商2024年度业绩快报抢先看

2024年,6家上市分销商中有3家实现归母净利润同比增长。

- Q1财测大降25%,安森美称将“精简”业务

在全球半导体行业面临增长放缓的背景下,安森美(onsemi)在2024年第四季度业绩下滑,并预计2025年第一季度营收将大幅下降。为应对市场挑战,公司宣布将采取“精简”业务等措施以提升竞争力……

- 计划融资超40亿,哪吒汽车等待“复活”

工厂正待复产……

- 巴黎AI峰会现分歧:联合声明遇冷,“空谈”质疑待解

当地时间2月10 - 11日,由法国、印度联合主办的人工智能行动峰会(AI Action Summit)在巴黎大皇宫隆重举行。

- 汽车巨头紧急呼吁重启美国50亿美元充电计划:仅建126个

美国50亿美元的电动汽车充电计划陷入停滞,仅建成126个充电桩。汽车巨头们终于坐不住了,紧急呼吁政府重启这一关键项目……

- 雷诺重启与富士康谈判,拟出售日产股份

在汽车行业智能化与电动化浪潮的冲击下,传统汽车巨头纷纷寻求战略转型与资本布局的优化……

- 2024年全球手机销量前十榜单公布,谁是全球销量冠军?

近日市场研究机构Counterpoint Research和Canalys均发布了2024年全球销量前十的手机榜单。虽然其中有部分机型或者排名不同,但这两份榜单均仅有苹果和三星两大品牌入选……

- 半导体市场增长强劲,2024年销售额首破6000亿美元大关

国际电子商情10日讯 最新数据显示,2024年全球半导体行业迎来了历史性突破,销售额首次突破6000亿美元大关,达到6276亿美元,同比增长19.1%……

- 长安、东风汽车同日宣布重组,市场猜测可能合并

2月9日晚,中国兵器装备集团有限公司(简称“兵器装备集团”)旗下长安汽车、长城军工、建设工业等上市公司发布通告,透露接到兵器装备集团的通知,集团正在与其他国资央企筹划重组事宜。同日,东风汽车集团有限公司(简称“东风公司”)旗下的东风股份、东风科技也宣布,东风公司正在探讨与其他国资央企的重组可能性。

- 豪掷180亿韩元,韩国计划投资MicroLED

国际电子商情8日讯 韩国正加速布局下一代显示技术,计划投资180亿韩元推动MicroLED等技术研发,以巩固其全球市场地位。

- 韩国芯片巨头Magnachip寻求再次出售,LX集团或成最大赢

国际电子商情8日讯 在显示器行业长期低迷的背景下,曾因美国干预而搁置出售计划的韩国芯片制造商Magnachip,在时隔数年后再度寻求出售……

- 软银65亿美元收购Ampere谈判进入尾声,最快本月官宣

国际电子商情8日讯 软银集团(SoftBank)以65亿美元(含债务)估值对美国芯片设计公司Ampere Computing LLC的收购交易接近达成,最快可能在本月官宣。交易若最终完成,将成为2025年全球半导体行业最具标志性的并购事件之一……

- 全球半导体设备市场,方兴未艾!

近日,Tokyo Electron(以下简称“TEL”)宣布,将在日本宫城县建造一座新的生产大楼,由TEL的制造子公司TEL宫城公司

- 中国北大研究团队,氮化镓技术获新进展

近日,北京大学物理学院杨学林、沈波团队,联合宽禁带半导体研究中心等多个科研机构,在氮化镓外延薄膜中位错的原

- 2025年数据中心五大趋势

数据中心/云计算可以说是人工智能领域的核心,占据了英伟达总收入的85%~90%。

- 重庆发布新政,聚焦高端芯片与器件发展

近日,重庆市人民政府办公厅印发《重庆市推动经济持续向上向好若干政策举措》,提出支持科技领军企业、产业链龙

- 消息称苹果取消Mac连接AR眼镜,独立AR眼镜研发仍推进中

2月10日消息,据彭博社记者马克·古尔曼报道,苹果公司取消了一款与Mac连接使用的AR眼镜项目,但仍在积极推进独立

- 三星2nmSF2工艺试产良率约30%?

韩国媒体TheBell报道,三星正在为旗下自研处理器Exynos2600投入大量资源,以确保其按时量产。

- 2024年Q4平板电脑市场整体增长放缓,iPad占据40%市场份额

尽管全球平板电脑市场在2024年的大部分时间都保持着两位数的增长,但在2024年Q4,平板电脑出货量仅同比增长3%。

- AR微显示厂商Cellid完成1300万美元融资

2月7日,日本AR眼镜光学厂商Cellid宣布,公司通过定向增发完成总额1300万美元(约人民币9478.95万元)的融资。

- 多家半导体大厂官宣换帅!

近日,多家媒体发布消息称,瑞芯微前副总经理陈锋将出任Arm在中国的合资公司安谋科技首席执行官(CEO)一职。

- 全球半导体厂商营收10强排行榜出炉!

美国市场研究机构Gartner发布2024年全球半导体厂商营收排行榜。

- 2024年先进封装晶圆占比近半

随着传统扩展方式的成本和复杂性上升,先进封装已成为满足人工智能(尤其是大型语言模型训练)性能需求的一种方式

- 2024年AIPC未能提振笔电市场,仅从2023年的低点温和增长5%

2024年Q4,全球笔记本电脑出货量同比增长了6%,达到5450万台。

- 英飞凌在泰国新建后道工厂,优化和丰富生产布局

英飞凌位于曼谷南部沙没巴干府的新后道厂破土动工,该厂将扩大公司在亚洲的生产布局。

- 芯耀辉:从传统IP到IP2.0,AI时代国产IP机遇与挑战齐飞

2024年,集成电路行业在变革与机遇中持续发展。面对全球经济的新常态、技术创新的加速以及市场需求的不断变化

- 艾睿电子与印尼初创协会合作,支持本地科技初创公司

雅加达,印尼- 2025年1月14日 - 全球技术解决方案供应商艾睿电子(Arrow Electronics)与印尼初创协会合作(STARFIN

- 【凯新达科技】新年欢聚,共绘年会精彩篇章!

无畏挑战 共创未来祥龙回首留胜景,金蛇起舞贺新程。在2025年元旦新年之际,深圳市凯新达科技有限公司(以下简

- CES 2025新品:摩尔斯微电子推出Wi-Fi芯片MM8108

最新Wi-Fi HaLow片上系统(SoC)为物联网的性能、效率、安全性与多功能性设立新标准;

配套USB网关,轻松实现Wi- - ST与彭水共绘可持续发展新篇章

随着与三安光电的碳化硅合资工厂落地重庆,2024年6月,意法半导体与重庆市彭水自治县同步启动了可持续发展合作

- 【凯新达科技】2025年度旅游活动景点精彩报道

凯新达科技 自由之旅 征途同行

- 超高性价比AI电脑:英伟达NVIDIA Jetson Orin Nano Super真香!iCEas

NVIDIA Jetson Orin™ Nano Super 开发者套件是一款尺寸小巧且性能强大的超级计算机,重新定义了小型边

- TI推出新一代支持边缘AI的雷达传感器和汽车音频处理器,改进车内驾

德州仪器今日推出了全新的集成式汽车芯片,能够帮助各个价位车辆的驾乘人员,实现更安全、更具沉浸感的驾驶体验

- 【原厂入驻】飞虹半导体现已入驻iCEasy商城!

广州飞虹半导体科技有限公司成立于广州越秀区,诚信经营20多年。主要研发、生产、经营:场效应管、三极管等半

- 携手共进,江波龙与电子五所在中山展开深度交流

近日,半导体存储品牌企业江波龙与工业和信息化部电子第五研究所(中国赛宝实验室,以下简称“电子五所”)在江波龙

- 【原厂入驻】迈巨微电子现已入驻iCEasy商城!

深圳迈巨微电子有限公司深耕锂电池管理芯片领域,围绕电池健康和安全,电池电量计算二个核心技术能力,提供完善的