热门标签

仅使用4片英伟达 GPU,搭配特制的SSD和软件,就可以用2至10万美金的成本来实现原本200万美金的AI模型微调运算能力。这可能吗?

犹记得,在去年3月CFMS MemoryS上,群联电子执行长潘健成向业界介绍aiDAPTIV+时,市面上AI大模型一体机还没有像如今这般盛行。那时,千亿级参数模型的单次训练成本动则数千万人民币,巨额的训练成本已经深入人心。当时,大家并不相信低成本方案能满足模型训练的需求,故而这类方案也未得到太多的市场反响。1GBesmc

1GBesmc

1GBesmc

群联电子执行长潘健成1GBesmc

令人意外的是,2025年初DeepSeek-R1模型爆火,社会各界开始关注起其背后的公司。DeepSeek公司通过DualPipe(一种创新双向流水线并行算法)、分层压缩引擎等算法革新和硬件协同优化,将模型训练的算力需求降低了46%-82%,模型推理算力消耗减少了97%,并推动单位算力效率提升3倍以上。所以,在此基础上低成本方案就变得切实可行,即使是预算有限的中小企业也可以够得着AI模型训练的门槛。1GBesmc

在今年的CFMS MemoryS上,潘健成再次介绍了aiDAPTIV+。这是群联电子通过将闪存、SSD与GPU结合,开发出的一种成本效益高的AI模型训练解决方案。它使用了4片英伟达GPU,搭配特制的SSD(也即aiDAPTIVCache)和软件,就可以用2至10万美金的成本来实现原本200万美金的AI模型微调运算能力,该方案被潘健成称为“平民的AI训练方案”。1GBesmc

艾媒咨询(iiMedia Research)《2024-2025年中国AI大模型市场现状及发展趋势研究报告》显示,2024年中国AI大模型市场规模约为294.16亿元,预计2026年将突破700亿元。由此可见,中国AI大模型行业正处于快速增长期。1GBesmc

自今年Q1开始,在各种行业峰会、研讨会上,“AI大模型推理一体机”成为了厂商力推的重磅产品。针对医疗、金融等垂直领域,已经有厂商将DeepSeek-V3等多模态大模型与推理优化引擎集成于AI推理一体机,让企业无需自建算力集群即可部署AI应用。1GBesmc

1GBesmc

1GBesmc

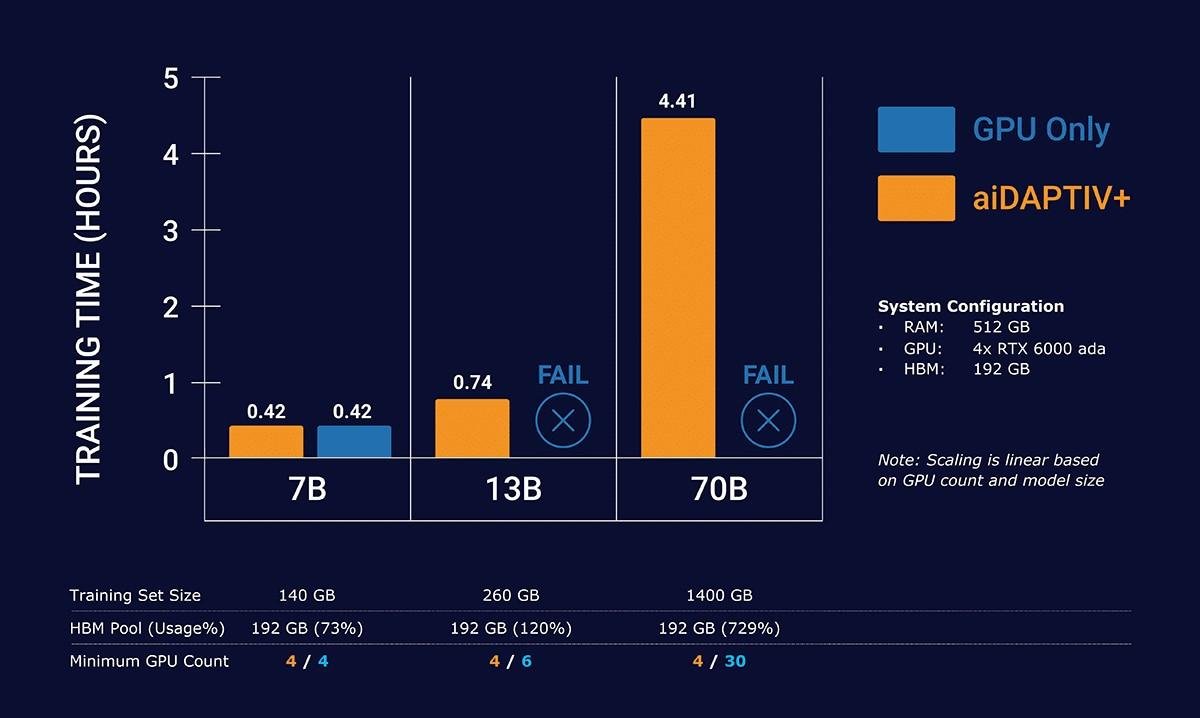

图1:aiDAPTIV+支持更高的参数量 图片来源:群联电子1GBesmc

而aiDAPTIV+的推出,要比今年雨后春笋般冒出的AI一体机更早,而且群联的aiDAPTIV+方案是同时支持AI模型微调训练与推理的“推训一体机”,对于地端边缘AI的订制化导入又更佳的便捷,更重要的是成本为一般的中小企业均可负担。潘健成在去年Q1就已经在公开演讲中分享该方案。根据他的介绍,aiDAPTIV+是面向AI训练的解决方案,该方案可在一台4卡工作站平台中完成Llama 70b模型的微调训练,容纳显存总量7倍以上的数据。1GBesmc

1GBesmc

1GBesmc

图2:群联电子aiDAPTIV+AI训练架构与传统AI训练架构对比 图片来源:群联电子1GBesmc

同时,aiDAPTIV+包含的中间件软件库(Middleware) 可将GPU显存中不活跃的AI模型层切片分离,在aiDAPTIVCache缓存固态硬盘(SSD)上暂放待处理的这些切片,并将GPU上已完成的部分与待处理的切片交换。此过程无需对AI应用本身进行修改。用通俗的话来解释,也即是“aiDAPTIV+是让GPU可以用NAND作为内存使用”。1GBesmc

在传统的AI训练架构中,模型权重(指模型中每个神经元连接的参数)需全部加载至HBM,以支持高频次计算,但随着AI模型的参数量越来越大,也就需要更多的HBM来满足需求,这也意味着更多的训练成本。aiDAPTIV+可以让GPU+HBM+DRAM+NAND Flash来做GPU AI运算的电脑架构。该技术本质是通过多级存储的动态调度,将NAND Flash纳入AI计算的数据链路,并与HBM、DRAM形成互补,从而突破传统架构的内存限制。1GBesmc

随着AI应用迅速向边缘端发展。DeepSeek的出现降低了大模型成本,继而推动了这一趋势。然而,未经微调的DeepSeek模型可能会给出不准确的回答,对模型进行微调是必要的。个人和企业手中的数据量非常大,且这些数据不会轻易上传到网络,需要把AI服务器放在本地并进行定制化处理。潘健成表示,这促使了群联电子将AI训练器件做得更便宜,以期让每一个普通人与“产官学”单位(指由企业、政府和大学/科研机构组成的合作单位)都能拥有自己专属的AI设备与AI助理服务。1GBesmc

具体来看,服务器方案的成本进一步降低,使得用户可以购买较为可负担的GPU盘来运行群联电子的AI方案。这不仅改变了用户的使用习惯,还增加了对NAND(aiDAPTIVCache与企业级SSD)的需求。随着AI在企业端的应用增加,NAND需求也将持续增长,消化这些需求则要很长时间。“边缘端AI的发展将给企业级SSD带来巨大的存储需求,如果国内100万家企业各部署1-2台AI一体机,其能够带来的SSD(aiDAPTIVCache)需求也相当庞大。另外,随着数据的快速积累,SSD的存储需求也会持续增加,”潘健成指出。1GBesmc

过去一年多,群联电子致力于将NAND与AI结合,以降低AI应用成本。虽然此前大家认为NAND与AI的直接关联不大,但公司已找到一种将二者结合的方法,并在此基础上实现成本平价化——让AI服务器或AI工作站可在家安装,同时具备训练和推理能力。1GBesmc

1GBesmc

1GBesmc

图3:群联电子的AITPC(人工智能训练电脑)1GBesmc

为了尽快推动aiDAPTIV+落地,以及帮助学生去学习“如何训练AI模型”而非只是“使用AI推理”,群联电子推出了AITPC(人工智能训练电脑; AI Training PC)。AITPC售价2.5万元人民币起,它基于传统台式机和显卡结构,无需更换硬件,只需简单集成,即可实现AI模型微调训练功能。其最大好处是——无需改变现有生态链,主板、显卡等硬件无需更换,只需在传统台式机上增加特定结构。用户只需在现有设备上进行简单操作就可完成升级。1GBesmc

升级后的设备可以用于AI训练和推理。在教育领域,AITPC为学生提供了实践一人一机的AI模型训练实际操作演练的机会,使他们能够更好地学习和理解AI的应用,更重要的是,学生可以学会如何在边缘地端微调训练AI模型,为特定的AI应用场景打造更合适的AI服务。此外,该设备也有助于推动AI技术的普及,让更多人能够接触和使用AI技术,促进相关技能的提升和创新。1GBesmc

针对最近各种AI一体机爆火的现状,潘健成评价道,边缘端AI一体机的工作方向非常正确,群联电子的aiDAPTIV+经过近1年9个月的开发,已从最初只提供硬件和中间软件,发展到如今涵盖更广泛的软件服务和功能。尽管在初期该方案的市场反应冷淡,绝大多数是因为企业端的AI专业人才不足,不知从何入门,但随着DeepSeek的爆火,市场开始认可低成本AI方案的可行性。如今,一些中国大陆企业在纷纷跟进。1GBesmc

据介绍,群联电子已经着手与国内的合作伙伴共同开发AI一体机。目前,铨兴科技联合浪潮云,发表预置DeepSeek-R1和DeepSeek-V3模型的海若一体机,率先实现671B满血版DeepSeek大模型单机服务,为政企客户提供大模型智能应用落地的一体化解决方案。铨兴科技的AI一体机正是基于群联电子的aiDAPTIV+技术的共同开发方案。1GBesmc

除此之外,群联电子也基于自己的AI一体机方案开发了Phison Code Pilot,帮助公司研发工程师员工提升工作效率。比如,在为美光开发汽车SSD主控项目中,群联电子的工程师需编写技术文件,其中涉及到16,000行程序码,若用传统方式需20人连续工作17周,而使用AI,在同样人力的情况下仅需两周;又如,在主控设计开发中,群联电子通过引入AI技术,减轻人力资源负担,并显着提高效率,在第一阶段已节省10%人力,未来将继续开发第二、第三阶段。1GBesmc

通过以上实践,群联电子展示了AI技术在提高效率、降低成本和推动创新方面的巨大潜力,为行业的发展提供了宝贵的经验和启示。在此基础上,潘健成呼吁更多志同道合的人加入合作,共同创造美好的边缘端AI应用。他强调说,AI产业广阔,需要软件公司、系统集成公司、硬件公司和经销商等共同努力,共同实践AI普及梦。1GBesmc

微信扫一扫,一键转发

关注“国际电子商情” 微信公众号

在庆祝创刊40周年之际,我们邀请了多位电子行业的资深人士,他们分享了自己的职业生涯和亲历的电子行业变迁。这些资深人士通过回顾全球电子行业的发展轨迹,围绕一些关键的转折点和代表性事件,探讨了行业的重要变革及其深远影响,并向年轻一代从业者传授了宝贵的经验。

根据上海证券交易所披露的纪律处分决定书,安徽安芯电子科技股份有限公司在申请科创板上市过程中,存在多项违规行为,被上交所处以一年内不接受其发行上市申请文件的纪律处分,其时任董事长及财务总监也被公开谴责。

临危受命?

巨头再接手

黄仁勋回应AI芯片需求和供应链。

余承东所言“全国人民买得起、意想不到的产品”长这样!

3月20日,日本软银集团宣布以65亿美元全现金收购美国芯片设计公司Ampere Computing,进一步深化其在人工智能(AI)基础设施领域的战略布局。

小米集团日前发布2024年第四季度及全年财报。2024 年小米实现全年总收入3659亿元,创历史新高,同比增长35.0%。

近日特斯拉中国官网显示,焕新Model Y长续航全轮驱动版价格上调了1万元。

又一家分销商加码自研IC业务!

国际电子商情讯,3月17日晚间,深圳英集芯科技股份有限公司发布公告称,公司决定终止购买辉芒微电子(深圳)股份有限公司控制权,公司芯股票自2025年3月18日开市起复牌。

全球前十大IC设计公司全年营收合计达2498亿美元,同比激增49%。其中,英伟达以1243亿美元营收蝉联榜首,占据前十总份额的50%,与其他厂商形成断层式差距。

Micro/Mini LED、车用LED、农业照明和UV / IR LED市场等领域仍保持增长。

当地时间3月18日,被称为“AI界春晚”的英伟达“GTC 2025”正式开场。

近日,2025年深圳市政府工作报告全文发布,其中集成电路被多次提及。

春节假期后,手机面板市场正式步入传统淡季。尽管“国补”政策带动终端热度延续,但因渠道库存仍在高位,第一季度

美通社消息,3月14日,“2025英飞凌消费、计算与通讯创新大会”(ICIC2025)在深圳举行。本届大会汇聚600多位业界精

近日,湖南省工信厅发布了《2025年湖南电子信息制造业重点项目名单》,涵盖先进计算、音视频、新一代半导体、人

3月15日,质鼎集团公众号消息,惠科东莞平板显示集群电子商务项目二期正式开工。

富士康、台积电、广达、华硕、联发科、友达光电等中国台湾20家电子企业2024年第四季度和全年财报汇总。

近年来,LED显示屏市场持续演进。回顾2024年,行业呈现出哪些发展态势?展望2025年及未来,市场又将面临哪些机遇与

近日,索尼正式发布新一代RGBLED背光技术系统,可实现4000尼特峰值亮度。索尼计划该系统将于2025年开始量产,并将

AI芯片是半导体最大的增长点,先进封装则是制造AI芯片的关键技术。此前英伟达H100成本约3000美元,而用先进封装

截止2024年底,17家欧美固态电池企业融资总额已突破42亿美元。

驱动工业自动化智能化升级,打造多场景视觉感知融合应用

高功率密度模块使大型望远镜能够追溯宇宙历史。

David Sheridan博士在接受《电子工程专辑》的采访中提到,SiC技术的成熟与电动汽车的普及几乎是同步进行的。

TE对于道德、合规和治理项目的承诺持续获得道德村协会的认可

德州仪器近日推出了全球超小型 MCU,进一步扩展了品类齐全的 Arm® Cortex®-M0+ MSPM0 MCU 产品组合。

创新是企业持续发展最大的价值。

“闪迪(Sandisk)又回来了!”在3月12日的存储年度盛会CFMS MemoryS 2025上,闪迪公司全球产品副总裁Eric Spa

摩尔斯微电子推出合规的Wi-Fi HaLow片上系统(Soc),开启欧洲连接技术新纪元。超低功耗、远距离连接功能现已为

CFMS | MemoryS 2025已圆满落幕,期间包括三星电子、长江存储、铠侠、美光、闪迪、高通、Arm、慧荣科技、S

Hyperlux™ ID iToF 系列将深度测量距离提升至最远 30 米,提高工业环境中的生产效率和安全性

26TB大容量CMR HDD助力WD Red Pro与G-DRIVE/G-RAID系列专业级产品矩阵,赋能数据存储拓展与生产力跃升

全新一代MCU可以满足各种区域控制架构和电气化系统需求,助力汽车制造商向软件定义汽车(SDV)过渡。

将出色的高

近期热点

EE直播间

更多>>在线研讨会

更多>> 点击查看更多

Copyright © 2000-2025 eMedia Asia Ltd. All rights reserved.

北京科能广告有限公司深圳分公司 版权所有

分享到微信

分享到微博

分享到QQ空间

推荐使用浏览器内置分享

分享至朋友圈