AI做出的“公平性”如何服众?

「什么是公平?」,就算是人类自己也没有统一的标准,它有时取决于语境。不论是在家里,还是在学校,教导小孩要公平是至关重要的,但说起来容易做起来难。正因为如此,我们要如何才能将社会上所说的「公平」的细微差别传递给AI系统呢?

什么是「公平」?就算是人类自己也没有统一的标准,它有时取决于语境。不论是在家里,还是在学校,教导小孩要公平至关重要,但说起来容易做起来难。正因为如此,要如何才能将社会上所说的「公平」的细微差别传递给人工智能(AI)系统呢?

IBM研究院的一组研究人员是着手解决该难题的先驱。IBM为开发人员推出了一款名为「AI Fairness 360」的工具包。作为这项工作的一部分,IBM为企业提供一种新的「基于云端的、偏差(bias)检测和消除服务」,企业可以使用它来测试和验证AI驱动的系统的行为。

在接受《EE Times》的电话采访时,IBM研究院院士Saska Mojsilovic告诉我们,科学家和AI从业者太过于关注AI的准确性。通常,人们关于AI的第一个问题是,「机器可以击败人类吗?」

但公平性呢?例如,AI中的公平无效可能会导致在医疗保健或自动驾驶车辆中造成灾难性后果,她说。

如果用于训练机器的数据集有偏差怎么办?如果AI无法解释它是如何做出决定的,那么如何才能验证其「正确性」?AI可以揭示在AI处理过程中数据是否被以某种方式操纵过吗?AI是否可以向我们保证其数据从未(包括处理前和处理后)受到攻击或篡改吗?简言之,是否存在AI自我反省?简单回答:没有。

Mojsilovic表示,如果不对AI用户、开发人员和从业者开放,AI系统就无法获得社会的信任。

分解公平

一个更大的问题是如何教导机器什么是公平。Mojsilovic指出:「因为我们是科学家,我们做的第一件事就是分解“公平性”,我们需要从这着手。」他们将公平分解为AI实现中的指针、算法和偏差。

X4Uesmc

X4Uesmc

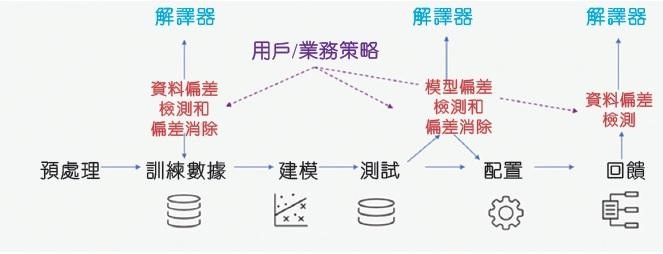

减少整个AI生命周期的偏差。(来源:IBM)

IBM研究科学家Kush Varshney解释,其团队研究了AI算法和AI决策的偏差和公平性。「有个人的公平,也有团体的公平。我们研究了群体的不同属性——从性别到种族,还考虑了法律和监管问题。」最后,团队最终测量了30个不同的指标,以寻找数据集、AI模型和算法中的偏差。

这些发现已纳入IBM不久前推出的AI Fairness 360工具包中。IBM将其描述为「一个全面的指标开放原始码工具包,用于检查数据集和机器学习模型中不期望的偏差。」

虽然许多科学家已经在努力发现AI算法中的歧视(discrimination),但Mojsilovic说IBM的方法不同,它不仅包括发现偏差的算法,且还包括用于消除偏差的工具。

在基础层面,你必定会问:由计算机科学家来定义公平?这通常不是社会科学家的任务吗?意识到这种不协调,IBM明确表示Mojsilovic和Varshney都没有闭门造车,他们导入了许多学者和研究机构的资料。Varshney参加了由卡内基国际事务伦理委员会(Carnegie Council for Ethics in International Affair)主办的Uehiro-Carnegie-Oxford伦理会议;Mojsilovic则参加了由加州大学柏克莱分校法学院(UC Berkeley Law School)赞助的加州柏克莱AI工作组。

算法中立吗?

这一段时间以来,社会科学家一直在指出AI偏差问题。

威斯康辛大学麦迪逊分校(University of Wisconsin, Madison)新闻与大众传播学院教授Young Mie Kim解释:「AI歧视(或AI偏差)可能发生在它隐含或明确地强化现有不平等的社会秩序和偏见(例如,性别、种族、年龄、社会/经济状况等)时。」例子从抽样误差(例如,由于抽样方法的不适当或困难导致某些人口统计资料不充分)到机器训练(建模)中的人为偏差。Kim认为,即使在设计或建模中采用的「战略决策」也存在AI偏差,例如政治广告算法。

在她最近题为《算法机会:数位广告和政治参与的不平等(Algorithmic Opportunity: Digital Advertising and Inequality of Political Involvement)》的研究中,Kim展示了在基于算法的决策中,不平等是如何被强化。

技术小区(technical community)可能会争辩说「算法是中立的」或者可以「受过教育」(训练有素)。Kim指出:「也就是说,他们并不承认在算法开发的任何阶段都会出现偏差。」

可解释的AI

不只是消费者害怕AI,许多计算机科学家也表达了担忧。威斯康辛大学计算机科学助理教授Aws Albarghouthi告诉《EE Times》:「从短期看,我担心越来越多地使用数据驱动的决策,这有可能传播偏见和不公正。从长远看,我担心AI在战争自动化方面的使用。」

AI无法解释其决策将带来持续焦虑。威斯康辛大学计算机科学助理教授Loris D'Antoni告诉我们:「现在,程序设计师开始将强大的机器学习算法作为程序设计工具箱中的工具。然而,这些算法复杂、难以预测、难以解释。例如,没人知道由此产生的机器学习模型究竟做了什么。」在他看来,自动化决策需要被理解和规范,并且可能以正规的方式进行。

对于流程的每个步骤,从训练数据和处理到测试与部署,IBM指出其工具包提供的解释可显示:在两种决策中、哪些因素倾向于支持哪一方;对推荐的信心,以及支持这种信心的因素。

IBM希望AI Fairness 360工具包将被广泛使用,以便开发人员可以为其做出贡献,帮助建立对AI的信任。与此同时,IBM将为企业提供其新的软件服务,旨在自动检测偏差并解释AI在需要做决策时,是如何做出决策的。它在IBM Cloud上运作,可协助企业管理AI系统。

IBM称,其在IBM Cloud上的公平性监控服务将与来自各种机器学习框架模型和AI构建环境(如Watson、 TensorFlow、SparkML、AWS SageMaker和AzureML)配合使用。「这意味着组织可以借力这些新控制以服务于企业使用的大多数流行的AI框架。」IBM也承诺提供定制服务,「还可对软件服务进行程序设计,以监控任何业务工作流程的独特决策因素,使其能够根据特定的组织用途进行定制。」

好的开始

越来越意识到AI中算法公平性问题的AI研究界,对IBM的新产品表示欢迎。D'Antoni告诉我们:「看到公平检查技术进入业界并付诸实践,真的令人兴奋。」他并补充,「我认为该工具将使AI研究界更加意识到该问题的重要性。」

Albarghouthi称IBM的努力「开创了好的开始」。但是为了让AI Fairness 360工具包真正变得有效,应该使许多需要理解它的开发人员能用到它。Albarghouthi解释,该工具需要「与研究界探索的最新公平技术并共同发展。」

他并告诫:「如果研究和理解超越了目前的定义和技术,那么该工具很可能会停滞不前。」

公平性问题

最后,任何成全或破坏AI公平性工具包的因素都会回溯到如何定义公平这一棘手问题。Mojsilovic承认,在不同应用中,公平有不同表现。正如人类对公平有不同看法,使用者、客户和公众可能会根据情况对公平有不同评判。

当被问及AI公平性工具包的缺陷时,Albarghouthi表示,问题之一是「存在于公平性定义的选择,以及其是否足够。」毕竟,公平「在很大程度上取决于领域、其敏感性和涉及的监管。」他补充:「我确信,这些工具只有在其使用成为机器学习管道的标准部分时才有效。」

D'Antoni表达了他自己的担忧。「有很多关于公平和偏差的定义,很难将它们全部考虑在内,且其实现也并非能毕其功于一役。」换句话说,「公平定义往往是“冲突的”,存在的不可能出现的结果表明,某些公平概念不能同时诉诸实施。」

此外,还有一个事实是「机器学习小区目前尚未接受过如何了解现有的公平和偏差定义的含义以及如何使用它们,」他补充。

Kim同意。「对这种“AI偏见”问题的认识是抵抗AI歧视的第一步,也是最重要的一步。」她指出:「在人类社会中,我们提出了一些减轻不平等和歧视的政策和法规。但问题是AI仍是个秘密,与大多数情况一样,数据和建模是专有的,这使得任何公共政策或监管讨论/辩论更加困难。」

透明度

理解了定义公平性时的复杂性和权衡取舍之后,IBM研究人员认为,优先事项应该是AI实践和实施的透明度。

Mojsilovic建议由AI服务开发商和供货商完成并自愿发布供货商的符合性声明(她称之为情况说明书)。「以提高其服务的透明度并产生对它们的信任。」她将其比作「食品营养卷标」,或「器具信息表」。

业界需要有关部署在不同服务中的AI系统信息的标准。IBM敏锐地意识到这不会在一夜之间发生,正如营养标签花了很长时间才逐步发展起来一样,情况说明书的开发可能是个漫长过程。Mojsilovic提醒,业界才刚刚开始其AI之旅。

与IBM类似,研究界也在与AI公平性问题斗争,在这个悬而未决的领域,IBM的AI Fairness工具包似乎具有开创性。D'Antoni告诉我们:「我并未注意到现有用于AI模型的通用公平性检查工具。」

另一方面,他补充:「研究界提出了许多令人兴奋的原型工具。例如,Kramer等人提出的FairTest和来自我们自己团队的FairSquare。」

(参考原文:Teaching Machines ‘Fairness’ ,by Junko Yoshida)

- 好文,引人深思!

AI,只要是人为编码,就会有,有意的,无意的公平性偏差,甚至选择性作弊。

这是我个人的看法。 - 好文,引发深思,AI只要是人为编码的,就会偏差,就可以作弊,这是我编码多年的看法。

-

微信扫一扫,一键转发

-

关注“国际电子商情” 微信公众号

- 巴黎AI峰会现分歧:联合声明遇冷,“空谈”质疑待解

当地时间2月10 - 11日,由法国、印度联合主办的人工智能行动峰会(AI Action Summit)在巴黎大皇宫隆重举行。

- 雷诺重启与富士康谈判,拟出售日产股份

在汽车行业智能化与电动化浪潮的冲击下,传统汽车巨头纷纷寻求战略转型与资本布局的优化……

- 解读年初9家半导体巨头财报:行业分化的信号与未来

大家今天都开工了吧?

- 半导体市场增长强劲,2024年销售额首破6000亿美元大关

国际电子商情10日讯 最新数据显示,2024年全球半导体行业迎来了历史性突破,销售额首次突破6000亿美元大关,达到6276亿美元,同比增长19.1%……

- 软银65亿美元收购Ampere谈判进入尾声,最快本月官宣

国际电子商情8日讯 软银集团(SoftBank)以65亿美元(含债务)估值对美国芯片设计公司Ampere Computing LLC的收购交易接近达成,最快可能在本月官宣。交易若最终完成,将成为2025年全球半导体行业最具标志性的并购事件之一……

- 2024年全球半导体市场增长18.1%,AI和数据中心成核心驱

国际电子商情7日讯 据市调机构Gartner近日发布的最新数据,2024年全球半导体市场收入总额达6260亿美元,同比增长18.1%,

- 豪掷9500亿韩元!韩国私募基金MBK Partners收购日本FICT

斥资9500亿韩元收购日本FICT,MBK Partners到底图什么?

- 特朗普关税影响,传台积电2025年先进制程报价或涨超15%

自特朗普开启第二任期以来,芯片关税的征收似乎已成定局。随着特朗普芯片关税逼近,有消息称台积电2025年先进制程价格大涨超15%以上……

- 全球市场“卖爆”!2024年中国芯片出口首破万亿元大关

全球芯片市场的激烈竞争中,中国芯片产业迎来了历史性突破。2024年,中国芯片出口首次突破1万亿元大关,成为全球市场的焦点。然而,尽管成绩斐然,高端芯片的进口依赖仍然显著,未来的挑战依然严峻……

- 日本电子巨头松下或出售电视业务!世上再无松下电视?

国际电子商情5日讯 日本电子巨头松下公司正在考虑出售或缩减其陷入困境的电视业务,集中力量发展人工智能数据中心等高利润领域……

- 台积电、格芯加码重金布局,2025年先进封装市场迎来新机

先进封装技术作为提升芯片性能的关键手段,正成为全球半导体产业竞争的焦点。进入2025年,尤其在人工智能、5G通信、汽车电子和高性能计算等新兴技术的推动下,市场对芯片的性能、功耗和集成度提出了更高要求,促使全球半导体厂商加大在先进封装技术研发和产能扩充上的投入。最近一段时间,格芯和台积电等巨头纷纷加码布局,美国补贴政策的落地,标志着一场围绕先进封装的全球竞争已然拉开帷幕……

- 史无前例,美国3.6万亿投资开启AI行业“星际之门计划”

当地时间1月22日上午,OpenAI正式官宣一项重大战略举措——启动“星际之门计划”(The Stargate Project)。该计划的核心是成立一家全新公司,旨在为OpenAI

- 全球半导体设备市场,方兴未艾!

近日,Tokyo Electron(以下简称“TEL”)宣布,将在日本宫城县建造一座新的生产大楼,由TEL的制造子公司TEL宫城公司

- 中国北大研究团队,氮化镓技术获新进展

近日,北京大学物理学院杨学林、沈波团队,联合宽禁带半导体研究中心等多个科研机构,在氮化镓外延薄膜中位错的原

- 2025年数据中心五大趋势

数据中心/云计算可以说是人工智能领域的核心,占据了英伟达总收入的85%~90%。

- 重庆发布新政,聚焦高端芯片与器件发展

近日,重庆市人民政府办公厅印发《重庆市推动经济持续向上向好若干政策举措》,提出支持科技领军企业、产业链龙

- 消息称苹果取消Mac连接AR眼镜,独立AR眼镜研发仍推进中

2月10日消息,据彭博社记者马克·古尔曼报道,苹果公司取消了一款与Mac连接使用的AR眼镜项目,但仍在积极推进独立

- 三星2nmSF2工艺试产良率约30%?

韩国媒体TheBell报道,三星正在为旗下自研处理器Exynos2600投入大量资源,以确保其按时量产。

- 2024年Q4平板电脑市场整体增长放缓,iPad占据40%市场份额

尽管全球平板电脑市场在2024年的大部分时间都保持着两位数的增长,但在2024年Q4,平板电脑出货量仅同比增长3%。

- AR微显示厂商Cellid完成1300万美元融资

2月7日,日本AR眼镜光学厂商Cellid宣布,公司通过定向增发完成总额1300万美元(约人民币9478.95万元)的融资。

- 多家半导体大厂官宣换帅!

近日,多家媒体发布消息称,瑞芯微前副总经理陈锋将出任Arm在中国的合资公司安谋科技首席执行官(CEO)一职。

- 全球半导体厂商营收10强排行榜出炉!

美国市场研究机构Gartner发布2024年全球半导体厂商营收排行榜。

- 2024年先进封装晶圆占比近半

随着传统扩展方式的成本和复杂性上升,先进封装已成为满足人工智能(尤其是大型语言模型训练)性能需求的一种方式

- 2024年AIPC未能提振笔电市场,仅从2023年的低点温和增长5%

2024年Q4,全球笔记本电脑出货量同比增长了6%,达到5450万台。

- 英飞凌在泰国新建后道工厂,优化和丰富生产布局

英飞凌位于曼谷南部沙没巴干府的新后道厂破土动工,该厂将扩大公司在亚洲的生产布局。

- 芯耀辉:从传统IP到IP2.0,AI时代国产IP机遇与挑战齐飞

2024年,集成电路行业在变革与机遇中持续发展。面对全球经济的新常态、技术创新的加速以及市场需求的不断变化

- 艾睿电子与印尼初创协会合作,支持本地科技初创公司

雅加达,印尼- 2025年1月14日 - 全球技术解决方案供应商艾睿电子(Arrow Electronics)与印尼初创协会合作(STARFIN

- 【凯新达科技】新年欢聚,共绘年会精彩篇章!

无畏挑战 共创未来祥龙回首留胜景,金蛇起舞贺新程。在2025年元旦新年之际,深圳市凯新达科技有限公司(以下简

- CES 2025新品:摩尔斯微电子推出Wi-Fi芯片MM8108

最新Wi-Fi HaLow片上系统(SoC)为物联网的性能、效率、安全性与多功能性设立新标准;

配套USB网关,轻松实现Wi- - ST与彭水共绘可持续发展新篇章

随着与三安光电的碳化硅合资工厂落地重庆,2024年6月,意法半导体与重庆市彭水自治县同步启动了可持续发展合作

- 【凯新达科技】2025年度旅游活动景点精彩报道

凯新达科技 自由之旅 征途同行

- 超高性价比AI电脑:英伟达NVIDIA Jetson Orin Nano Super真香!iCEas

NVIDIA Jetson Orin™ Nano Super 开发者套件是一款尺寸小巧且性能强大的超级计算机,重新定义了小型边

- TI推出新一代支持边缘AI的雷达传感器和汽车音频处理器,改进车内驾

德州仪器今日推出了全新的集成式汽车芯片,能够帮助各个价位车辆的驾乘人员,实现更安全、更具沉浸感的驾驶体验

- 【原厂入驻】飞虹半导体现已入驻iCEasy商城!

广州飞虹半导体科技有限公司成立于广州越秀区,诚信经营20多年。主要研发、生产、经营:场效应管、三极管等半

- 携手共进,江波龙与电子五所在中山展开深度交流

近日,半导体存储品牌企业江波龙与工业和信息化部电子第五研究所(中国赛宝实验室,以下简称“电子五所”)在江波龙

- 【原厂入驻】迈巨微电子现已入驻iCEasy商城!

深圳迈巨微电子有限公司深耕锂电池管理芯片领域,围绕电池健康和安全,电池电量计算二个核心技术能力,提供完善的